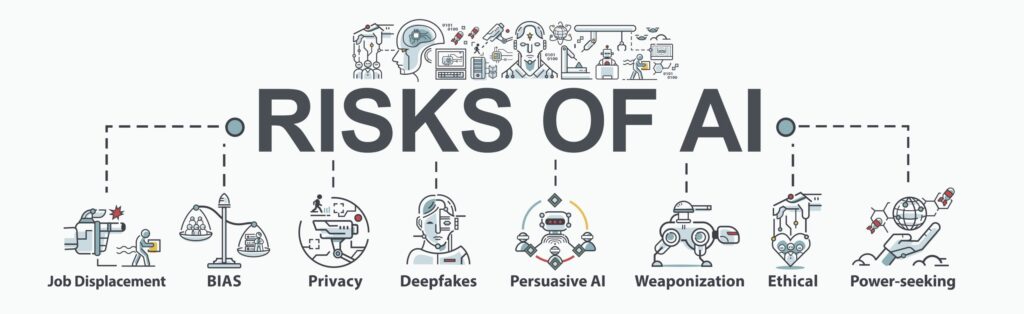

Il NIST ha pubblicato uno studio sui tipi di attacchi informatici che manipolano il comportamento dei sistemi di intelligenza artificiale e ha creato delle strategie per mitigarli.

Il National Institute of Standards and Technology (NIST) ha pubblicato un rapporto che illustra nel dettaglio le tipologie di attacchi informatici che potrebbero essere mirati ai sistemi di intelligenza artificiale e le possibili difese contro di essi.

L’agenzia ritiene che tale studio sia fondamentale perché le attuali difese contro gli attacchi informatici ai sistemi di intelligenza artificiale e ai dati con cui vengono “educate” sono scarse, in un momento in cui l’intelligenza artificiale pervade sempre più tutti gli aspetti della vita e del lavoro.

Intitolato “Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations”, il rapporto inizia sviluppando una tassonomia e una terminologia dell’adversarial machine learning. Il rapporto copre due grandi tipologie di IA: l’IA predittiva e l’IA generativa. Questi sistemi sono addestrati su grandi quantità di dati, che i malintenzionati possono corrompere, perché questi set di dati sono troppo grandi per essere monitorati e filtrati.

Gli avversari possono deliberatamente confondere o addirittura “avvelenare” i sistemi di intelligenza artificiale per farli funzionare male, e non esiste una difesa infallibile contro la compromissione dei dati immessi nelle IA.

Il NIST ha, quindi, ritenuto necessario identificare le vulnerabilità dell’intelligenza artificiale e dell’apprendimento automatico.

Il loro lavoro (NIST.AI.100-2), fa parte di uno sforzo più ampio del NIST per supportare lo sviluppo di un’intelligenza artificiale affidabile e può aiutare a mettere a punto il quadro di gestione del rischio AI del NIST. La pubblicazione, frutto di una collaborazione tra governo, mondo accademico e industria, ha lo scopo di aiutare gli sviluppatori e gli utenti a comprendere i tipi di attacchi che potrebbero aspettarsi insieme agli approcci per mitigarli.

Machine learning contraddittorio

I sistemi di intelligenza artificiale hanno permeato la società moderna, lavorando con capacità che vanno dalla guida di veicoli, alla diagnostica, all’interazione con i clienti. Per imparare a svolgere questi compiti, vengono addestrati su grandi quantità di dati: a un veicolo autonomo potrebbero essere mostrate immagini di autostrade e strade con segnali stradali, ad esempio, mentre un chatbot basato su un modello linguistico di grandi dimensioni (LLM) potrebbe essere esposto a registrazioni di conversazioni online. Questi dati aiutano l’intelligenza artificiale a prevedere come rispondere in una determinata situazione.

Uno dei problemi principali è che i dati stessi potrebbero non essere affidabili. Le fonti possono essere siti web e interazioni con il pubblico. Esistono molte opportunità per i malintenzionati di corrompere questi dati, sia durante il periodo di addestramento di un sistema di intelligenza artificiale che successivamente, mentre l’intelligenza artificiale continua a perfezionare i suoi comportamenti interagendo con il mondo fisico.

Per assistere la comunità degli sviluppatori e dei system integrator, il nuovo rapporto offre una panoramica dei tipi di attacchi e i corrispondenti approcci per ridurre i danni.

Il rapporto considera i quattro principali tipi di attacchi: evasione, avvelenamento, attacchi alla privacy e abusi. Li classifica, inoltre, in base a molteplici criteri come gli scopi e gli obiettivi, le capacità e le conoscenze dei cyber criminali.

Evasion attacks

Si verificano dopo l’implementazione di un sistema di intelligenza artificiale, tentano di alterare un input per cambiare il modo in cui il sistema risponde ad esso. Gli esempi includono l’aggiunta di segnaletica orizzontale ai segnali di stop per fare in modo che un veicolo autonomo li interpreti erroneamente come segnali di limite di velocità o la creazione di segnaletiche di corsia confuse per far deviare il veicolo fuori strada, ecc…

Poisoning attacks

Gli attacchi di avvelenamento avvengono nella fase di addestramento introducendo dati corrotti. Per esempio un hacker può inserire numerosi esempi di linguaggio inappropriato nei registri delle conversazioni, in modo che un chatbot interpreti questi esempi come un linguaggio abbastanza comune da poter essere utilizzato nelle proprie interazioni con i clienti. O, ancora, potrebbe inserire consigli errati e pericolosi a precisi argomenti rendendo il sistema IA un sistema di social engineering!

Privacy attacks

Gli attacchi alla privacy si verificano durante la distribuzione, sono tentativi di apprendere informazioni sensibili sull’IA o sui dati su cui è stata addestrata per abusarne. Un avversario può porre a un chatbot numerose domande legittime e quindi utilizzare le risposte per decodificare il modello in modo da trovarne i punti deboli o indovinarne le fonti. Aggiungere esempi indesiderati a quelle fonti online potrebbe far sì che l’intelligenza artificiale si comporti in modo inappropriato, spinga l’utente a rivelare ulteriori informazioni, ecc… ed è difficile, poi, eradicare un comportamento appreso.

Abuse attacks

Questi comportano l’inserimento di informazioni errate in una fonte, come una pagina web o un documento online, che un’intelligenza artificiale poi assorbe. A differenza degli attacchi di avvelenamento sopra menzionati, gli attacchi di abuso tentano di fornire all’IA informazioni errate da una fonte legittima ma compromessa in maniera da potarla modificare al modificarsi del proprio target o scopo.

NIST Mitigation Framework

Le misure difensive da adottare includono l’aumento dei dati di input con esempi contraddittori durante l’addestramento dell’IA utilizzando etichette corrette, il monitoraggio delle metriche prestazionali standard dei modelli ML, l’utilizzo di tecniche di monitoraggio dei dati, tecniche di rilevamento, soluzioni protezione e backup multilivello, la collaborazione con esperti di cyber security e l’awareness per gli utilizzatori finali.

Scopri il nostro Security Operations center:

scopri le nostre soluzioni per la sicurezza informatica:

Post vacanze: adeguamento alla Direttiva NIS 2 entro Ottobre 2024!

Pinnacle Award a Cisco EVE: sicurezza e visibilità nel traffico criptato

Ransomware: perdite in crescita del 500% a causa dell’autenticazione obsoleta

CISCO Cyber Vision per l’Operational Technology

Apulia Cybersecurity Summit, Next-Gen Solutions – Bari, 7 Giugno 2024

- Blog (69)

- Case Studies (19)

- Eventi (2)

- News (68)

- Luglio 2024 (4)

- Giugno 2024 (1)

- Aprile 2024 (2)

- Marzo 2024 (2)

- Febbraio 2024 (3)

- Gennaio 2024 (1)

- Dicembre 2023 (1)

- Novembre 2023 (4)

- Agosto 2023 (2)

- Luglio 2023 (3)

- Maggio 2023 (1)

- Marzo 2023 (3)

- Febbraio 2023 (2)

- Gennaio 2023 (3)

- Dicembre 2022 (2)

- Novembre 2022 (2)

- Ottobre 2022 (4)

- Settembre 2022 (2)

- Agosto 2022 (1)

- Luglio 2022 (4)

- Giugno 2022 (3)

- Maggio 2022 (3)

- Aprile 2022 (3)

- Marzo 2022 (3)

- Febbraio 2022 (3)

- Gennaio 2022 (2)

- Dicembre 2021 (4)

- Novembre 2021 (2)

- Ottobre 2021 (4)

- Settembre 2021 (4)

- Luglio 2021 (2)

- Giugno 2021 (1)

- Maggio 2021 (8)

- Aprile 2021 (27)

- Marzo 2021 (7)